研究人员已经开发了一种新的可以在不获取图像或不需要复杂场景重建的情况下检测多个物体的位置、大小和类别的快速方法。由于这种新方法大大地减少了目标检测所需的计算能力,因此它可能在驾驶中识别危险时非常有用。北京理工大学的研究团队负责人Liheng Bian说“我们的技术基于单像素检测器,可以直接从少量二维测量中实现高效、稳健的多目标检测,这种无图像感知技术有望解决现有视觉感知系统存在的通信负荷大、计算消耗大、感知率低等问题。”

现在的无图像感知方法只能实现分类、单个目标识别或跟踪。为了同时完成这三项工作,研究人员开发了一种称为无图像单像素目标检测 (SPOD) 的技术。这项研究成果已经发表《Optics Letters》期刊上,他们在论文中介绍SPOD可以实现超过80%的目标检测精度。该技术是建立在他们之前将无成像传感技术开发为高效场景感知技术的成果之上。他们之前的工作包括基于单像素检测器的无图像分类、分割和字符识别。Bian说:“对于自动驾驶,SPOD 可以与激光雷达一起使用以提高场景重建速度和目标检测精度,我们相信它具有足够高的自动驾驶检测率和精度,同时也降低了物体检测所需传输带宽和计算资源的要求。”

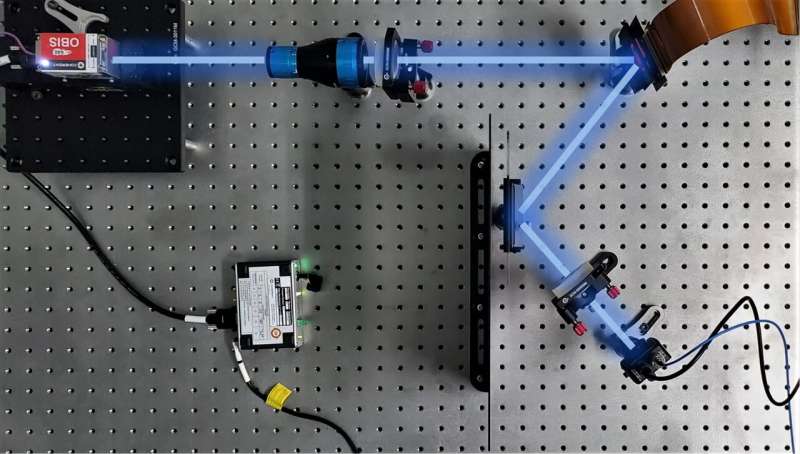

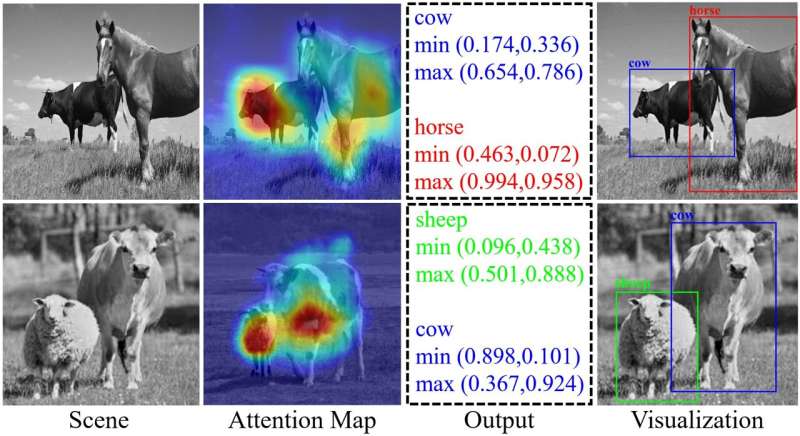

研究人员开发了一种新的可以在不获取图像或不需要复杂场景重建的情况下检测多个物体的位置、大小和类别的快速方法。上图展示了无图像单像素目标检测(SPOD)的概念验证装置。图片来源:Lintao Peng, 北京理工大学。

无图像检测

无论是用于导航车辆还是跟踪移动飞机的自动化高级视觉任务,通常需要场景的详细图像以提取识别物体所需的特征。然而,这需要复杂的成像硬件或复杂的重建算法,从而导致计算成本高、运行时间长和数据传输负载大。因此,传统的先成像、后感知的方法可能并不适合进行目标检测。基于单像素检测器的无图像传感方法可以降低物体检测所需的计算能力。与使用像素化探测器(如CMOS或CCD)不同,单像素成像使用一系列结构光模式照亮场景,然后记录透射光强度以获取物体的空间信息,然后利用这些信息来计算重建对象或计算其属性。

研究表明在5%的采样率和63 FPS的刷新率下,SPOD的检测精度达到82.41% mAP。可视化结果如图所示。图片来源:Lintao Peng, 北京理工大学。

对于SPOD,研究人员利用小型但经过优化的结构光模式快速扫描整个场景并获得 2D 测量值,这些测量值被输入到基于变压器的编码器的深度学习模型中,以提取场景中的高维有意义的特征。然后将这些特征输入到基于多尺度注意力网络的解码器中,该解码器同时输出场景中所有目标的类别、位置和大小信息。研究团队成员Lintao Peng说“与其他单像素检测方法使用的全尺寸模式相比,经过优化的模式能产生更好的无图像传感性能,此外,SPOD解码器中的多尺度注意力网络增强了网络对场景中目标区域的注意力,从而更有效地提取场景特征,实现最先进的目标检测性能。”

概念验证演示

为了实验验证SPOD,研究人员搭建了一个概念验证装置。从Pascal Voc 2012测试数据集中随机选择图像,并将其打印在胶片上作为目标场景。当采用5%的采样率时,利用SPOD完成每个场景的空间光调制和无图像目标检测的平均时间仅为 0.016 秒。这比先进行场景重建(0.05 秒),然后进行目标检测(0.018 秒)要快得多。对于测试数据集中包含的所有目标类别,SPOD的平均检测准确率为82.2%。Peng 说:“目前,由于用于训练模型的现有目标检测数据集只包含80种类别,因此SPOD无法检测到所有可能的目标类别,但是,当面对特定任务时,可以对预训练模型进行微调,以实现对新目标类别的无图像多目标检测,例如行人、车辆或船只检测等应用。”接下来,研究人员计划将无图像感知技术扩展到其他种类的检测器和计算采集系统,以实现无重建感知技术。

消息来源:https://phys.org/news/2023-05-multiple-images.html

[1]Lintao Peng et al, Image-free single-pixel object detection, Optics Letters (2023). DOI: 10.1364/OL.486078

客服热线:

客服热线: